Router, Switch, Arpanet. Drei Begriffe, die man heutzutage kennen sollte, denn alle drei haben mit der Vernetzung von Rechnern und anderen Geräten zu tun. Daher lernen Sie in diesem Netzwerk-Special eine Menge zu Router, Switch und Co.

Sieht man sich die Geschichte des Computernetzwerks an, beginnt dessen Erfolgsstory in Zeiten des Kalten Kriegs, nämlich Ende der 1970er Jahre. Genauer gesagt 1969, da ging nämlich das Arpanet online, das vier US-amerikanische Universitäten miteinander verband. Die Absicht dahinter: Es sollte ein dezentrales Rechennetzwerk entstehen, das auch noch dann funktioniert, wenn einer der zugehörigen Mainframe-Computer durch Sabotage oder ähnliches ausfällt.

Heute nennen wie das Arpanet „Internet“, und die Idee ist immer noch dieselbe. Nur das aus vier Zentralrechnern viele Millionen Webserver geworden sind, die allesamt miteinander verbunden sind.

Mit dem Entstehen des Arpanet fand auch der paketgestützte Datentransfer namens X.25 eine große Beachtung. Damit war es möglich, Datenpakete über eine nahezu beliebte Anzahl von Rechnern zu übermitteln, bis die Daten an ihrem Zielort angekommen sind. In diesen Genuss kamen dann Ende der 1980er Jahre auch Privatanwender, die dank öffentlicher Zugänge an Universitäten die Anfänge des Internets nutzen und erleben durften.

Tim Berners-Lee, „Vater“ des heutigen World Wide Web

Fest verknüpft mit den Anfängen des Internets, so wie wir es heute kennen, ist der Name Tim Berners-Lee, der am CERN in Genf das World Wide Web erfand. Und das nur, weil sich das CERN sowohl auf französischem als schweizerischem Boden befand (und immer noch befindet), was die Kommunikation zwischen den einzelnen Rechnern sehr erschwerte. Und so gab Berners-Lee 1990 das Internet in seiner aktuellen Form für die breite Öffentlichkeit frei.

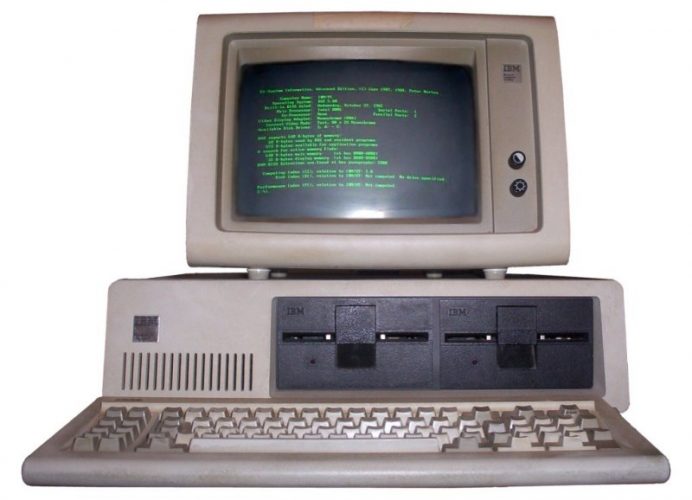

Während dieser Jahre, genauer gesagt ab 1981 mit Einführung des ersten IBM PCs namens 5150, startet die Vernetzung von PCs auch innerhalb lokaler Rechenumgebungen ihren Siegeszug. Für die interne Kommunikation der einzelnen Rechner mussten diese miteinander verbunden werden, was seinerzeit noch spezielle Hard- und Software erforderte. Erst mit der Einführung von Windows 3.11 und Windows NT mit ihren netzwerktauglichen Protokollen kam Schwung in das Thema Vernetzung für jedermann.

[irp posts=“159395″ ]

Ethernet und TCP/IP sorgen für massentaugliche Netzwerke

Zeitgleich zur Vernetzung im großen Stil machte eine Technik von sich Reden, die noch heute aktuell ist und die sich in den letzten 40 Jahren zu der Standard-Netzwerktechnik schlechthin gemausert hat. Gemeint ist Ethernet, diese Übertragungstechnik über Kupferleitung.

Heute basiert die komplette Netzwerktechnik in großen Teilen auf Ethernet, da sie sich kostengünstig und sehr einfach implementieren lässt. Dank seiner zunehmenden Bandbreite von 40 und mehr Gigabit kommen Ethernet-Netzwerke auch vermehrt in Hochleistungsumgebungen wie Storage-Netzwerken zum Einsatz.

Der breitangelegte Erfolg von Ethernet ist mit einer weiteren Technik eng verzahnt, ohne die es das Internet und lokale Netze in der heutigen Form nicht gäbe: TCP/IP. Dieses Transportprotokoll sorgt dafür, dass Daten genau dort ankommen, wo sie landen sollen, selbst unter schwierigen Bedingungen.

Hierfür nutzt TCP/IP eine Technik, die auf optimaler Verständigung beruht. Denn nur dann, wenn zwei Rechner bereit sind, ein einzelnes Datum wie ein Musikstückschnipsel oder ein Fragment eines Bildes zu übertragen und zu empfangen, kommt der Datenaustausch zustande. TCP/IP entstand übrigens während der Entwicklung des Arpanet und spielt daher für den Internet-Boom eine große Rolle.

[irp posts=“157422″ ]

TCP/IP, HTTP, IMAP: diese Protokolle gibt es

Das wohl bekannteste Protokoll nennt sich TCP/IP, was für Transmission Control Protocol/Internet Protocol steht. Im Grunde ist es eine Protokollfamilie, die sich aus den Teilen TCP und IP zusammensetzt. Bekannt ist es deshalb, da jeglicher Internetverkehr, aber auch das Versenden und Empfangen lokaler Daten über das TCP/IP-Protokoll erfolgt.

Mindestens genauso berühmt ist HTTP, eine Kurzform von Hypertext Transfer Protocol. Es sorgt dafür, dass die Webseiten, die auf einem Webserver gespeichert sind, von einem Internetbrowser wie dem Internet Explorer, Firefox oder Google Chrome richtig dargestellt werden. HTTP wird auch als Dateiübertragungsprotokoll benutzt.

Immer, wenn Sie eine E-Mail empfangen oder versenden, kommen drei Protokolle ins Spiel: POP3, SMTP und IMAP. Dabei sorgt das Post Office Protocol Version 3 (POP3) für das Abrufen von E-Mail-Nachrichten vom Mailserver, das Simple Mail Transfer Protocol (SMTP) hingegen kümmert sich um das Versenden von E-Mails über den E-Mail-Server. Da POP3 und SMTP diverse Nachteile aufweisen, kommt für das Versenden und Empfangen von Mails immer häufiger das Internet Message Access Protocol (IMAP) zum Einsatz.

Aber auch das File Transfer Protocol (FTP) hat seine Berechtigung: Damit lassen sich Daten von einem lokalen Rechner auf einen Server übertragen und von dort aus auf einen anderen PC transferieren. Allerdings verliert FTP in Zeiten von Blogsystemen wie WordPress immer mehr seine Bedeutung.

[irp posts=“33425″ ]

Diese Aufgaben erledigen Protokolle

Protokolle kümmern sich vor allem um den Verbindungsaufbau zwischen zwei Endgeräten wie einem Notebook und einem Smartphone. Aber auch die zuverlässige Datenübertragung gehört zu den Aufgaben eines Netzwerksprotokolls. Sollte dabei etwas schief gehen, kümmert sich das Protokoll um den erneuten Zustellversuch eines Datenpakets. Wichtig dabei ist auch die richtige Reihenfolge, in der mehrere Datenpakete beim Empfänger ankommen sollen. Auch dafür sind die Protokolle zuständig.

Typischer Aufbau eines Protokolls

Jedes Protokoll verfolgt einen bestimmten Aufbau, der für den fehlerfreien Datenaustausch erforderlich ist. Hierfür wird beispielsweise festgelegt, wie Absender und Empfänger heißen, damit alle anderen Rechner innerhalb eines Netzwerks die entsprechenden Datenpakete ignorieren.

Zudem wird bestimmt, um welchen Pakettyp es sich handelt, wie groß das Datenpaket ist, aus wie vielen Teilen die Datenübertragung besteht und einiges mehr. Wichtig dabei sind auch sogenannte Prüfsummen, die mithilfe bestimmter Berechnungen feststellen, ob sich ein Datenpaket während der Übertragung vom Empfänger zum Sender verändert hat. Sollte das nämlich der Fall sein, wird der erneute Datenversand initiiert.

Router: Datenvermittler mit eigener Intelligenz

Ein Router wie die allseits bekannte Fritzbox von AVM hat vor allem zwei Funktionen: Er leitet Datenpakete vom Sender zum Empfänger und blockiert diese bei Bedarf. Dabei weiß der Router stets, für wen die Daten bestimmt sind, die ihn gerade erreichen. Hierzu steht ihm eine sogenannte Routing-Tabelle zur Verfügung, in der steht, über welche Schnittstelle das jeweilige Datenpaket weitergeleitet bzw. zugestellt werden soll. Diese Informationen stehen auf Basis des TCP/IP-Protokolls bereit. Ganz ähnlich funktioniert das Blockieren unerwünschter Datenpakete, die Hacker unbemerkt in Datennetze einzuschleusen versuchen.

Auf dem Markt tummeln sich zahlreiche Router-Typen, die je nach Anwendungsbereich bestimmten Anforderungen genügen. Für Betreiber von Onlineshops kommen beispielsweise Highend-Geräte in Betracht, die über redundante Komponenten wie ein zweites Netzteil verfügen, um so die Wahrscheinlichkeit eines Router-Ausfalls zu minimieren.

Daneben existieren zahlreiche, weniger leistungsfähige Router-Modelle wie die Fritzbox, die aufgrund ihrer umfangreichen Ausstattung echte Allrounder sind. Diese Low-Cost-Geräte lassen sich vor allem in kleineren Firmen und Agenturen einsetzen. Dazu gehören zweifelsohne die Router von AVM, die allerdings kaum die Sicherheit bieten, die in vielen Firmen unabdingbar ist.

[irp posts=“158019″ ]

Switches: Schneller Datentransfer für lokale Netze

Ein Switch verfügt im Gegensatz zum Router über keine eigene „Intelligenz“, sondern verbindet lediglich mehrere Rechner miteinander und leitet ankommende Daten weiter. Daher geschieht die Datenübertragung zwischen TCP- und Hardware-Ebene, und nicht wie bei den Routern auf IP-Basis. Hierzu kennt der Switch sämtliche Ethernet-Ports der angeschlossenen Computer und speichert diese in einer zugehörigen Tabelle. Kommt ein Datum am Switch an, kann dieser das Paket direkt weiterleiten. Daher geschieht der Datentransport über Switches meist sehr schnell.

Für das noch schnellere Weiterleiten von Daten kommen diverse Methoden zum Einsatz, eine der Schnellsten nennt sich „Fragment Free“. Dabei werden Datenpakete erst ab einer bestimmten Größe weitergeleitet, um somit die Datenvermittlung von ganz kleinen Paketen zu unterbinden.

[irp posts=“29629″ ]

Repeater & mehr: Reichweite erhöhen und Hotspots schaffen

Vor allem in Netzwerken, in denen Anwender häufig mit Notebook, Smartphone und Tablet unterwegs sind, spielen drahtlose WLAN-Router eine große Rolle. Für die bessere Erreichbarkeit oder eine höhere Reichweite bietet sich der Einsatz zweier Spezialgeräte an: Repeater und Wireless Access Point.

Repeater verbinden sich zu diesem Zweck drahtlos mit dem WLAN-Router und können damit die Reichweite eines drahtlosen Netzwerks deutlich erhöhen. Hierfür lassen sich sogar mehrere Repeater in einem Netzwerk installieren.

Wireless Access Point hingegeben fungieren als drahtloser Zugangspunkt in einem Netzwerk, so wie man das von öffentlichen Hotspots kennt. Der Access Point ist wiederum per Kabel mit einem Router verbunden, der die Datenpakete dann zum gewünschten Empfänger weiterleitet – sei es lokal innerhalb eines abgeschlossenen Netzwerks oder via Internet an einen entfernten Rechner.

Das sollte man über Firewalls wissen

Das Funktionsprinzip einer Firewall ist recht simpel: Der ein- und ausgehende Datenverkehr wir anhand bestimmter Regeln überwacht. Sobald ein oder mehrere Datenpakete eine dieser Regeln verletzten, blockiert die Firewall den Datenstrom und schützt damit das lokale Netzwerk vor fremden Zugriffen oder Bedrohungen. Hierfür kommen diverse Lösungen infrage, die entweder als reine Software-Anwendung oder als Hardware-Firewall feilgeboten werden. Die möglichen Firewall-Schutzvorrichtungen weisen zahlreiche Unterschiede auf und erhöhen damit den Schutz von kaum bis bestmöglich.

[irp posts=“32740″ ]

Kaum Schutz vor Eindringlingen: Software-Firewalls

Zahlreiche Firewall-Programme buhlen um die Gunst der Käufer, immer mit dem Versprechen verknüpft, einen robusten Schutz zu bieten. Für private Anwender mag das noch halbwegs stimmen, da der PC, auf dem die Firewall-Software installiert ist, vor unliebsamen Besuchern geschützt wird. Für Firmen mit mehreren Rechnern gilt das schon nicht mehr, da es meist schon genügt, mit geringem Aufwand den PC von außen solange mit gefälschten oder massenhaften Daten zu „beschießen“, bis entweder die Schutzsoftware oder der Rechner in die Knie gehen.

Mehr Schutz, wenngleich eingeschränkt: Router-Firewalls

In jedem heute verfügbaren (WLAN-)Router steckt eine Firewall, und das mit den mehr oder weniger ähnlichen Schutzmechanismen. Ob Paket- und Content-Filter, Stateful Packet Inspection oder DMZ (Demilitarized Zone) – Fritzbox und Co. beherrschen die wichtigsten Filterfunktionen, mit denen die guten von den schlechten Datenpaketen getrennt werden können.

Allerdings, und darin unterscheidet sich ein Router von einer expliziten Firewall-Appliance (s. nächster Abschnitt), schützen diese Geräte aufgrund der geringen Rechenleistung und der nicht vorhandenen Funktionen ein Netzwerk nur eingeschränkt. Für kleinere Firmen und Home Offices mit geringen Sicherheitsbedenken mag das ausreichen – für alle anderen nicht.

Noch mehr Schutz für kleinere und mittelgroße Firmen: Firewall-Appliances

Wer es deutlich sicherer will als mit den Router-Firewalls sollte zu dedizierten Hardware-Firewalls greifen, die es in mannigfaltiger Ausprägung am Markt gibt. Dieses Geräte unterscheiden sich vor allem in der Hardware-Ausstattung. Dazu zählt speziell der verbaute Prozessor, der darüber befindet, wie viele Datenverbindungen parallel überwacht werden können. Das wieder bestimmt den Sicherheitsgrad eines Netzwerks, das von der Firewall überwacht wird. Aber auch die Zahl der möglichen Verbindungen von außen ins Firmennetzwerk (sogenannte VPN-Tunnel) variiert von Gerät zu Gerät.

Netzwerkschutz at its best: Next Generation Firewalls

Im Gegensatz zu den traditionellen Firewalls, die wie beschrieben rein datenpaket-orientiert arbeiten, können die Firewalls der nächsten Generation (NGF) Anwendungen und Benutzer im Datenstrom erkennen. Hierfür nutzen sie Techniken wie IPS (Intrusion Prevention System), mit denen sich Protokolle und Anwendungen unabhängig von ihren Einfallskanälen (Ports) identifizieren lassen. Ziel des Ganzen ist das Erkennen von manipulierten Datenpaketen, die beispielsweise mithilfe einer Anwendung wie einem Browser in das Netzwerk eingeschleust werden sollen. Damit arbeiten Next Generation Firewalls sehr viel kontextbasierter als die herkömmlichen Firewall-Lösungen.

Wissenswertes zum Thema Ethernetkabel

Bis vor ein paar Jahren tummelten sich diverse Netzwerkkabel am Markt, übrig geblieben davon ist vor allem eins: Ethernet-Kabel vom Typ Twisted Pair. Der Name beruht darauf, das sich in solch einem LAN-Kabel vier Kupferdrahtpaare befinden, was eine bessere Abschirmung vor elektromagnetischen Störquellen wie Stromleitungen bedeutet, die solch einem Übertragungsmedium ausgesetzt ist. Darunter würde nämlich die Datenrate leiden, was man tunlichst vermeiden will.

Wenn es aber nur noch Twisted Pair Ethernetkabel gibt, worin unterscheiden sie sich überhaupt? Nun, die zwei wesentlichen Unterschiede betreffen die Abschirmung und die Übertragungsfrequenz des Kabels. Beides wirkt sich auf die Übertragungsleistung, sprich auf die mögliche Geschwindigkeit bei der Datenübertragung aus.

UTP oder STP: Auf die richtige Ummantelung kommt es an

Ethernetkabel gibt es in den Ausprägungen „geschirmt“ (STP; Shielded Twisted Pair) und „ungeschirmt“ (UTP; Unshielded Twisted Pair). Ungeschirmte Kabel weisen eine schlechtere Übertragungsleistung als STP-Kabel auf, wenn damit längere Strecken überbrückt werden sollen. Daher sollte man zu UTP-Kabel nur dann greifen, wenn man PCs verkabeln will, die sich beispielsweise in einem Raum oder im selben Stockwerk befinden. Darüber hinaus sollten die zu übertragenden Daten nicht sonderlich störanfällig sein. Bei Video- und Musikdaten ist das beispielsweise der Fall.

Von STP bis S/FTP: Darin unterscheiden sich geschirmte LAN-Kabel

Geschirmte LAN-Kabel weisen unterschiedliche Materialien zum Schutz vor Störquellen auf, wovon die genaue Bezeichnung und der Schutzgrad abhängt. So nennen sich Kabel mit einer Aluminiumfolie als Abschirmung Foiled Twisted Pair (FTP), kommt hingegen ein Kupfergeflecht zum Einsatz, nennt sich das zugehörige Kabel STP (Screened Twisted Pair).

Darüber hinaus gibt es am Markt Kombinationen aus beiden Abschirmungstechniken, die sich S/STP (Screened Shielded Twisted Pair) und S/FTP (Screened Foiled Twisted Pair) nennen. Dabei werden je zwei Aderpaare gegeneinander abgeschirmt. Diese Kabeltypen kommen vor allem in störanfälligen Gigabit-Netzwerken zum Einsatz.

[irp posts=“158581″ ]

CAT5 bis CAT7: Eine Frage der Übertragungsqualität

Bei den Twisted Pair-Kabeln sind derzeit drei Kategorie von Relevanz: CAT5, CAT6 und CAT7. Diese unterscheiden sich vor allem in der Betriebsfrequenz, für die sie ausgelegt sind, was direkten Einfluss auf die Übertragungsqualität hat. So versenden und empfange CAT5-Kabel, die stets vom Typ UTP sind, Daten auf einer Frequenz von 100 MHz. Sie sind für hohe Übertragungsraten und geringe Störeinflüsse geeignet.

CAT6-Kabel (ebenfalls vom Typ UTP) übertragen Daten auf einem 250-MHz-Spektrum und kommen in 10-Gigabit-Netzwerken zum Einsatz, die ebenfalls relativ frei von Störquellen sind. Bei CAT7-LAN-Kabeln handelt es stets um STP-Modelle mit unterschiedlicher Ummantelung. Diese Kabel senden und empfangen auf 600 MHz bzw. 1000 MHz und sind für störanfällige 10-Gigabit-Netzwerke konzipiert.

Netzwerk-Zusatzgeräte: Powerline-Adapter, Printservern und Co.

Speziell in mehrstöckigen Einfamilien- und Reihenhäusern, in denen das drahtlose Signal des WLAN-Routers nicht alle Netzwerkteilnehmer erreicht, stellen Powerline-Adapter eine erprobte Erweiterung des WLAN-Signals dar. Diese kleinen Geräte werden hierzu einfach nur paarweise mit jeweils einer Steckdose verbunden, und schon findet der Datenaustausch zwischen zwei (W)LAN-Teilnehmern über die Stromleitung statt.

Dabei wir normalerweise der Router per Ethernetkabel mit dem einen Powerline-Adapter und der andere drahtlos oder per LAN-Kabel mit dem zweiten Adapter verbunden. Das Ergebnis eine verbesserte Reichweite und eine höhere Datenübertragungsrate als mit einer ausschließlich drahtlosen WLAN-Verbindung.

Printserver: Gemeinsames Drucken im Netzwerk

Anstatt für jeden Netzwerkrechner einen eigenen Drucker bereit zu stellen, erlauben sogenannte Print- oder Druckerserver den gemeinsamen Zugriff durch mehrere Anwender auf einen Drucker oder ein Multifunktionsgerät. Hierfür wird der Printserver mit dem USB- oder Ethernet-Anschluss des Druckers verbunden, der Zugriff darauf erfolgt dann entweder über das kabelgebundene oder drahtlose Ethernet-Netzwerk.

Spezielle Printserver wie der DPR-1020 von D-Link bieten sogar die Möglichkeit, auf Funktionen zuzugreifen, die nur Multifunktionsgeräte bieten. Die Rede ist vom dezentralen Kopieren, Faxen und Scannen mithilfe des Druckerservers. Diese Netzwerkkomponenten können unter Windows, Mac OS X und Linux betrieben werden.

Repeater: Erhöhung der drahtlosen Reichweite

Ganz ähnlich wie die Powerline-Adapter erhöhen sogenannte Repeater die Reichweite eines lokalen Networks, allerdings nur auf WLAN-Basis. Hierfür verbinden sich Repeater und Router auf demselben Frequenzband miteinander, sodass die Daten vom Computer des Anwenders zunächst auf dem Repeater und anschließend auf dem Router landen, von wo sie aus beispielsweise mit einem anderen Netzwerkteilnehmer ausgetauscht werden können.

Auf diese Weise findet auch der Zugriff auf das Internet statt. Bei der Wahl des passenden Repeaters sollte auf eine bestmögliche Kompatibilität geachtet werden. So bietet beispielsweise die Firma AVM zu ihren Fritzbox-Router-Modellen dazu passende Fritzbox-Repeater, die sich quasi per Knopfdruck miteinander verbinden lassen.