Mit einer Komponente namens IPU will Intel den Betreibern von Rechenzentren und Cloud-Infrastrukturen ein Stück Technik an die Hand geben, die ihnen neue Möglichkeiten und mehr Leistung bei gleichzeitig geringeren Kosten ermöglichen soll. Doch was hat es mit den Infrastructure Processing Units auf sich und worin bestehen die wesentlichen Unterschiede zu den DPUs anderer Hersteller wie Nvidia? Damit beschäftigt sich der folgende Blogbeitrag.

Ganz klar: In Rechenzentren und in der Cloud kommt es neben der reinen Rechenleistung auf einen weiteren wesentlichen Aspekt an, und der hat mit dem Datentransport zu tun. Denn gerade dort, wo möglichst geringe Latenzzeiten bei Datentransfers von A nach B ein hohes Gut darstellen, spielt die richtige Ausstattung eine immer größere Rolle. Gleichzeitig soll diese neue Komponente den Hauptprozessor von weiteren Aufgaben wie dem Ver- und Entschlüsseln von Daten entlasten. Denn in Zeiten von zunehmenden Ransomware-Attacken auf Cloud-Infrastrukturen ist eine hochperformante Kryptografie unentbehrlich.

[irp posts=“159254″ ]

Für schnellere und sicherere Datentransfers: IPU

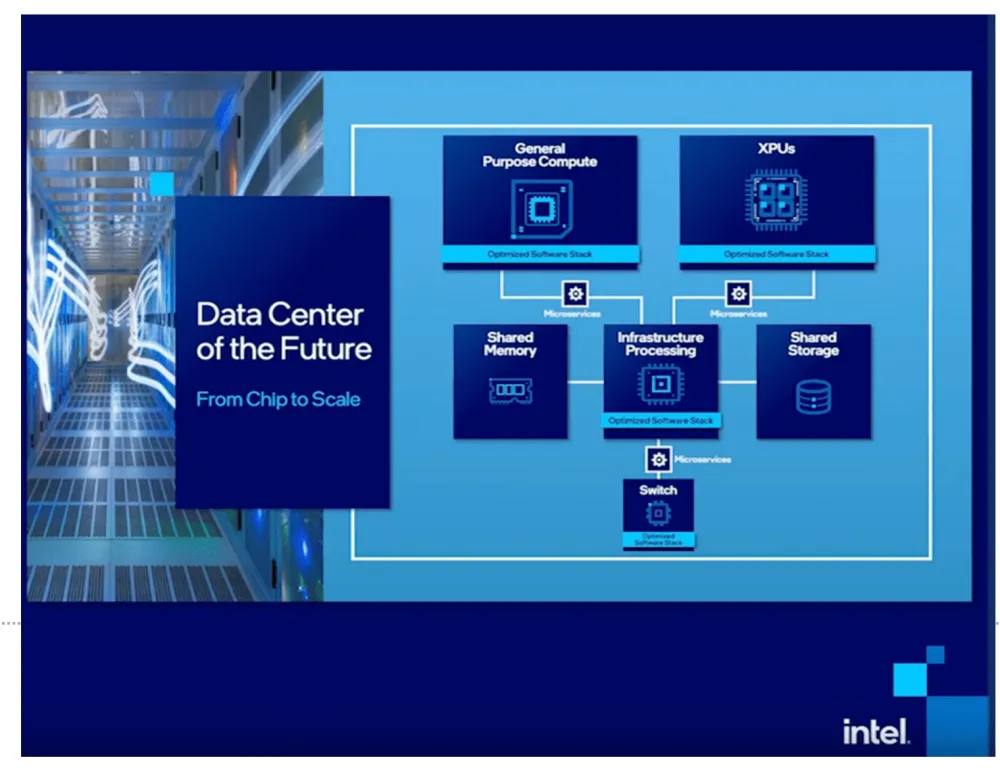

So also kam Intel auf die Idee, eine neue Komponente namens IPU zu entwickeln. Der Ansatz dahinter ist recht naheliegend: Anstatt den Hauptprozessor des Zentralrechners in Kombination mit einem Netzwerk-Chip die Arbeit machen zu lassen, könnte man doch das Ganze auf ein einziges, neu konzipiertes Stück Silizium packen. Prozessornahe und weitere Funktionen inklusive. Herausgekommen ist ein Chip, der sich Infrastructure Processing Unit nennt.

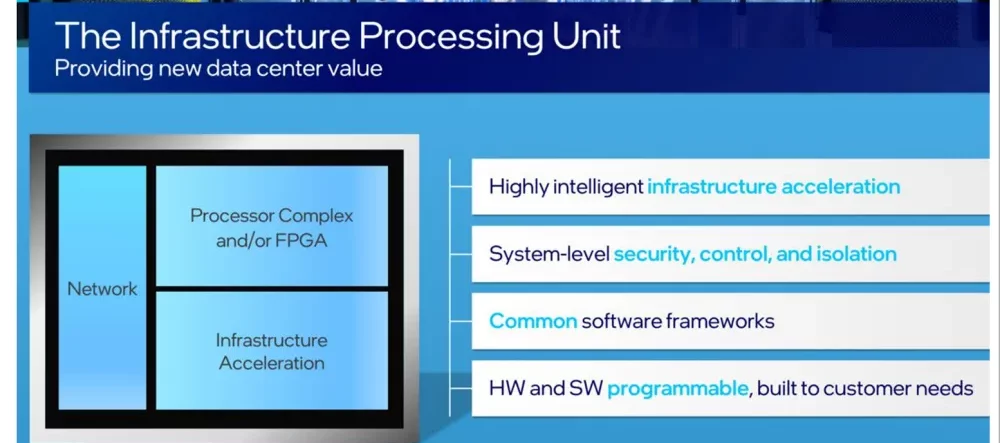

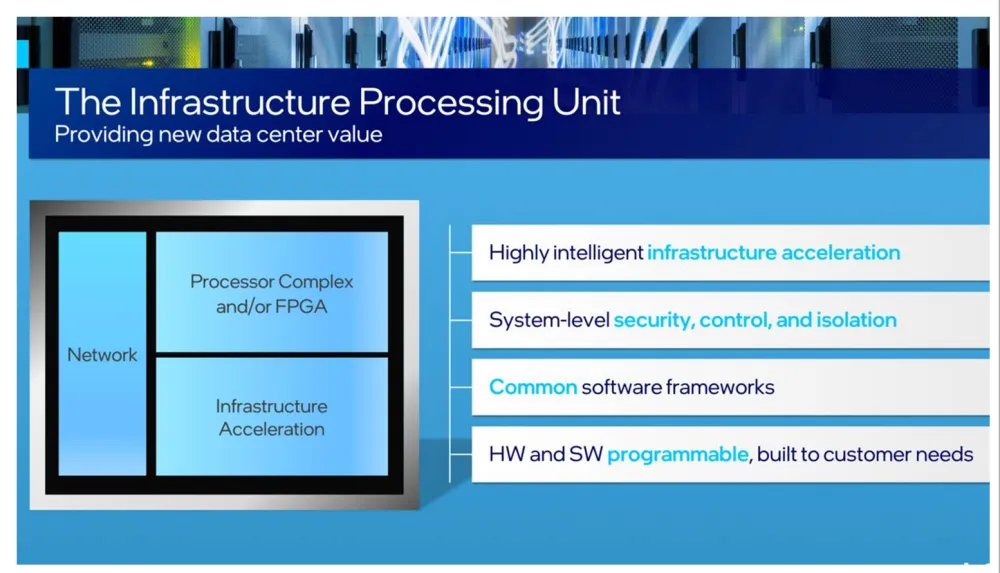

Wie der Name vermuten lässt, ist eine IPU ein Konglomerat aus drei wesentlichen Funktionen bzw. Einheiten. Damit steuert der Chip die Datenflüsse über das bestehende Netzwerk und fungiert gleichzeitig als programmierbarer FPGA. Darüber hinaus beherrscht eine IPU die komplette Klaviatur in Sachen Sicherheit, Speicherverwaltung und mehr. Und wegen seiner Progammierfähigkeiten lässt sich der Chip an die jeweilige Umgebung bestmöglich anpassen.

IPU vs. DPU Das können die neuen Netzwerkchips besser

Im Gegensatz zu den am Markt schon länger befindlichen DPUs (Data Processing Units), die Nvidia und andere Hersteller schon eine ganze Weile im Portfolio haben, ist eine IPU also keine SmartNIC im klassischen Sinne.

Das macht sich alleine schon an dem Prozessor fest, die in der IPU für die Berechnungen sorgt. Dort kommt nämlich eine Intel Xeon CPU zum Einsatz, im Gegensatz zu Arm-Prozessoren, die in einer DPU stecken. Die daraus resultierenden Vorteile des IPU-Xeon-Ansatzes habe ich ja hier schon eingehend betrachtet.

[irp posts=“168611″ ]

Aber auch im Einsatz einer FGPA-Einheit zeigt sich der verbesserte Ansatz von IPU-Chips im Vergleich zur DPU-Technik. Das kann so weit gehen, dass Intel schon heute von einem möglichen Tausch der FGPA-Units durch ASIC-Bausteine spricht.

[irp posts=“158983″ name=“7 gute Gründe für Intel-basierte Cloud-Infrastrukturen“]

IPUs im Einsatz: Inventec FPGA SmartNIC C5020X

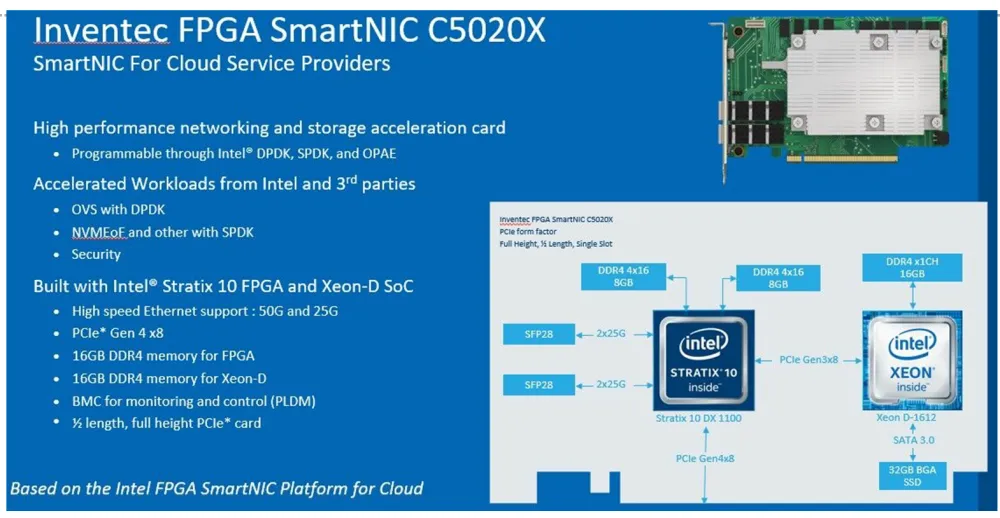

Solch eine technologische Idee ist ohne die passenden Komponenten nicht viel wert. Und so steht den Cloud Service Providern dieser Welt eine IPU-kompatible SmartNIC namens Inventec FPGA SmartNIC C5020X zur Verfügung. Damit lassen sich Cloud-Rechner um all die Funktionen erweitern, die auf der IPU-Technik basieren.

Dazu gehören verbesserte Datentransferraten und Latenzzeiten, ein beschleunigter Zugriff auf die vorhandenen Speichereinheiten sowie eine Beschleunigung diverser Workloads. Dazu gehören z.B. Open vSwitch mit DPDK-Support, NVMEoE und weitere Anwendungsszenarien.

Hardware-seitig ist in der Inventec-Karte ein Intel Stratix 10 FGPA sowie ein Intel Xeon D-Prozessor verbaut. Damit sind 25- und 50 Gigabit-Ethernet-Anbindungen möglich, sowie Shared Memory für die FGPA- und die CPU-Einheit.

IPU-Partner: Microsoft Azure, VMware & Co.

Die SmartNIC-Idee auf IPU-Basis findet bei den Großen der IT-Zunft Gefallen. So setzt unter anderem VMware diese Kombination aus Hochleistungsprozessor und programmierbarer Logik schon eine ganze Weile ein, und zwar im Rahmen des Projekts „Monterey“. Damit sollen flexiblere Rechenzentren entstehen, die einen besseren TCO als herkömmliche NIC-Lösungen aufweisen.

[irp posts=“160095″ ]

Disclaimer: Für das Verfassen und Veröffentlichen dieses Blogbeitrags hat mich die Firma Intel beauftragt. Bei der Ausgestaltung der Inhalte hatte ich nahezu freie Hand.