Ein neues Schlagwort macht schon eine ganze Weile die große KI-Runde: Generative AI (kurz: GenAI). Doch was hat es damit auf sich, und welche Anwendungen profitieren davon schon heute? Diese und weitere Fragen beantwortet der folgende Blogpost.

Die Generative Künstliche Intelligenz (GenAI) beschreibt bestimme Anwendungen (wie ChatGPT), mit deren Hilfe sich neue Inhalte erstellen lassen, und das mit relativ geringem Aufwand. Dazu gehören Musikstücke, Programmcodes, Bilder, Texte, Simulationen und Videos. GenAI-basierte Applikationen wie DALL-E von OpenAI zeigen, welches Potenzial in dieser neuen Art und Weise der Inhaltserstellung steckt.

Auf der diesjährigen Hannover Messe durfte ich mit Ricky Watts von Intel ein Video drehen, in dem wir der Frage nachgingen, welche Vorteile GenAI der fertigenden Branche bringt, wer es braucht und was Intel damit zu tun hat.

Sehr oft handelt es sich nämlich um unstrukturierte Daten, also um Videos, Social Media-Beiträge, Bilder, Audiodateien und mehr. Hinzu kommt, dass es sich – neben der enormen Mengen an Daten – um sehr aufwändig zu verarbeitende Datenformate handelt. Und das ist genau die Stelle, an der Generative AI zum Zuge kommt.

Mithilfe der zugehörigen Deep Learning-Algorithmen lassen sich die vorhandenen Daten schneller und exakter analysieren als mit herkömmlichen KI-Ansätzen. So können diese verarbeiteten Daten quasi in Echtzeit darüber befinden, an welchen Stellen der Anwendung Verbesserungs- bzw. Optimierungsbedarf besteht. Was sich dann eben – in Echtzeit – in besseren Applikationen niederschlägt. Was das im Einzelnen in Bezug auf bestimmte Anwendungen bedeutet, sollen die folgenden Beispiele verdeutlichen.

Large Language Modelle (LLM) profitieren von SmoothQuant

Large Language Modelle wie BLOOM sind in der Lage, auf Basis von Milliarden von Parametern KI-getriebene Anwendungen mit Daten zu füllen und daraus neue Anwendungsfälle zu generieren. Damit lassen sich beispielsweise Texte erstellen, die kaum von denen zu unterscheiden sind, die von Menschenhand stammen. ChatGPT ist ein hierfür bekanntes Beispiel.

Das Besondere an den LLM ist deren Fähigkeit, 16 Bit-Floating-Point-Daten mithilfe einer Technik namens Quantifizierung in deutlich „schlankere“ 8-Bit-Integer-Daten umzuwandeln, und das ohne Einbußen bei der Genauigkeit der Ergebnisse. Die Vorteile liegen auf der Hand: Diese Berechnungen lassen sich schneller ausführen, zudem benötigen die ermittelten Resultate bzw. Daten weniger Speicherplatz. Allerdings lassen sich die herkömmlichen Quantifizierungsalgorithmen auf LLM nur bedingt gut anwenden.

Daher wurde eine Technik entwickelt, die sich SmoothQuant nennt, die vor allem der Intel Xeon Prozessor der 4. Generation besonders gut beherrscht. Damit lassen sich LLM deutlich schneller und effizienter quantifizieren, und das ohne Qualitätseinbußen. Für all diejenigen, die ein Onlinetool ausprobieren möchten, das auf LLM und SmoothQuant basiert, sei diese zugehörige Seite empfohlen. Dahinter verbirgt sich ein Chat-Bot, der seine Rechenintelligenz von einem einzigen Intel Xeon Prozessor der 4. Generation bezieht.

Netflix verbessert mithilfe von Generative AI die Streamingqualiät

Auf der diesjährigen Intel Vision Konferenz Anfang Mai war unter anderem der Streaminganbieter Netflix vertreten. Dort durften Armen Ather und sein Team zeigen, wie sich mithilfe von GenAI signifikant Speicherplatz sparen und gleichzeitig die Streamingqualität optimieren lässt.

Hierfür verfolgen die Experten bei Netflix drei Ansätze, mit denen das Videostreaming besser wird. Zum einen wurden große Teile des Quellcodes um die CPU-Funktionen Intel AVX-512 und Intel AVX512 VNNI erweitert. Damit lassen sich vor allem Algorithmen, die im Wesentlichen auf Fließkomma-Parametern basieren, erheblich beschleunigen. Zum anderen setzen Armen und seine Kolleg:innen auf das Intel-Tool VTune Profiler. Damit lassen sich Anwendungen auf mögliche Schwachstellen und Flaschenhälse untersuchen, um so ein Leistungsoptimum erzielen zu können.

Der enorme Aufwand, der mit dem Kodieren unterschiedlicher Videostreams einher geht, lässt sich zudem mithilfe der Intel oneAPI Deep Neural Network Bibliothek (oneDNN) beschleunigen, indem AVX512 VNNI genutzt wird. Netflix spricht in diesem Fall von einer Videokodierung, die doppelt so schnell wie ohne den Einsatz von oneDNN erfolgt.

So vereinfacht die Programmierumgebung Intel oneAPI die Software-Entwicklung

Numenta verbessert den Datendurchsatz um ein Vielfaches

BERT (Bidirectional Encoder Representations from Transformers) ist eine Spracherkennungstechnik, die vor etwa 5 Jahren von Google der Öffentlichkeit vorgestellt und dieser auch zur Verfügung gestellt wurde. Mit BERT lassen sich kontextuelle Beziehungen von Texten deutlich besser erfassen als mit ähnlichen Natural-Language-Processing-Modellen (NLP). So kommt BERT beispielsweise schon seit Jahren in den Google-Algorithmen für bessere Suchergebnisse zum Einsatz.

Aber auch Firmen wie Numenta aus Redwood City, Kalifornien, setzen auf die rechnerische Kraft von BERT. So kommt die NLP-Technik auf deren KI-Plattform zum Einsatz, die von deren Kunden zum Trainieren aufwändiger NLP- und LLM-basierter Anwendungen sind. Das reicht von einfachen Chatbots bis hin zu hochkomplexen Tools, mit denen sich beispielsweise Verträge in einem Bruchteil der sonst hierfür benötigten Zeit analysieren lassen.

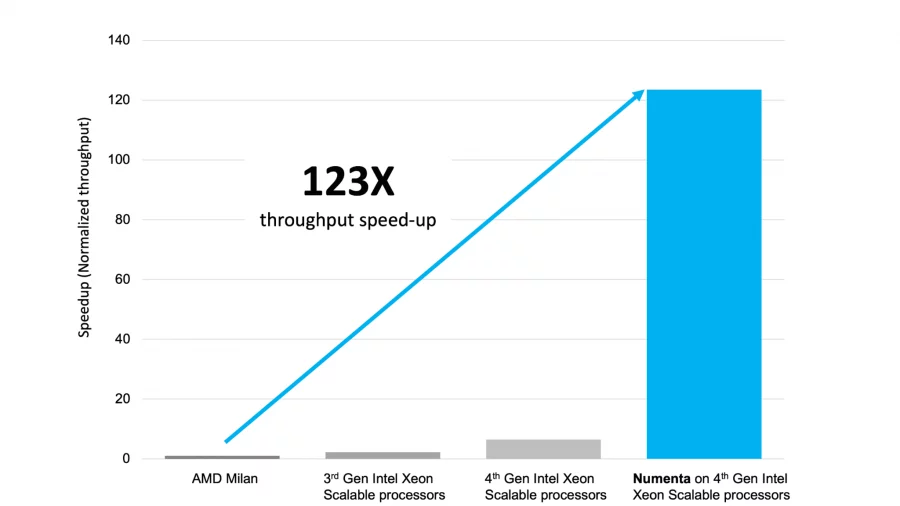

Das Besondere an der Numenta KI-Plattform ist deren hoher Optimierungsgrad, die sie unter Verwendung des Intel Xeon Prozessors der 4. Generation aufweist. So konnte der Datendurchsatz bei BERT-basierten Anwendungen um den enormen Faktor von 123 verbessert werden. Diese Steigerung kommt hauptsächlich durch den Einsatz der CPU-Beschleunigungsfunktion Intel Advanced Matrix Extensions (Intel AMX) zustande.

Fazit: Noch nie war die Zeit für echte künstliche Intelligenz so günstig wie dieser Tage. Denn mit dem Erscheinen von GenAI-basierten Tools wie Chat GPT und DAll-E und den technologischen Möglichkeiten eines Intel Xeon CPU-basierten Rechners (4. Generation) werden völlig neue Applikationen und Services möglich. Intelligente Chat-Bots und Tools zur Bildgenerierung sind da nur der Anfang.

KI-Lexikon: Wichtige Begriffe der Künstlichen Intelligenz erklärt

Disclaimer: Für das Verfassen und Veröffentlichen dieses Blogbeitrags hat mich die Firma Intel beauftragt. Bei der Ausgestaltung der Inhalte hatte ich nahezu freie Hand.